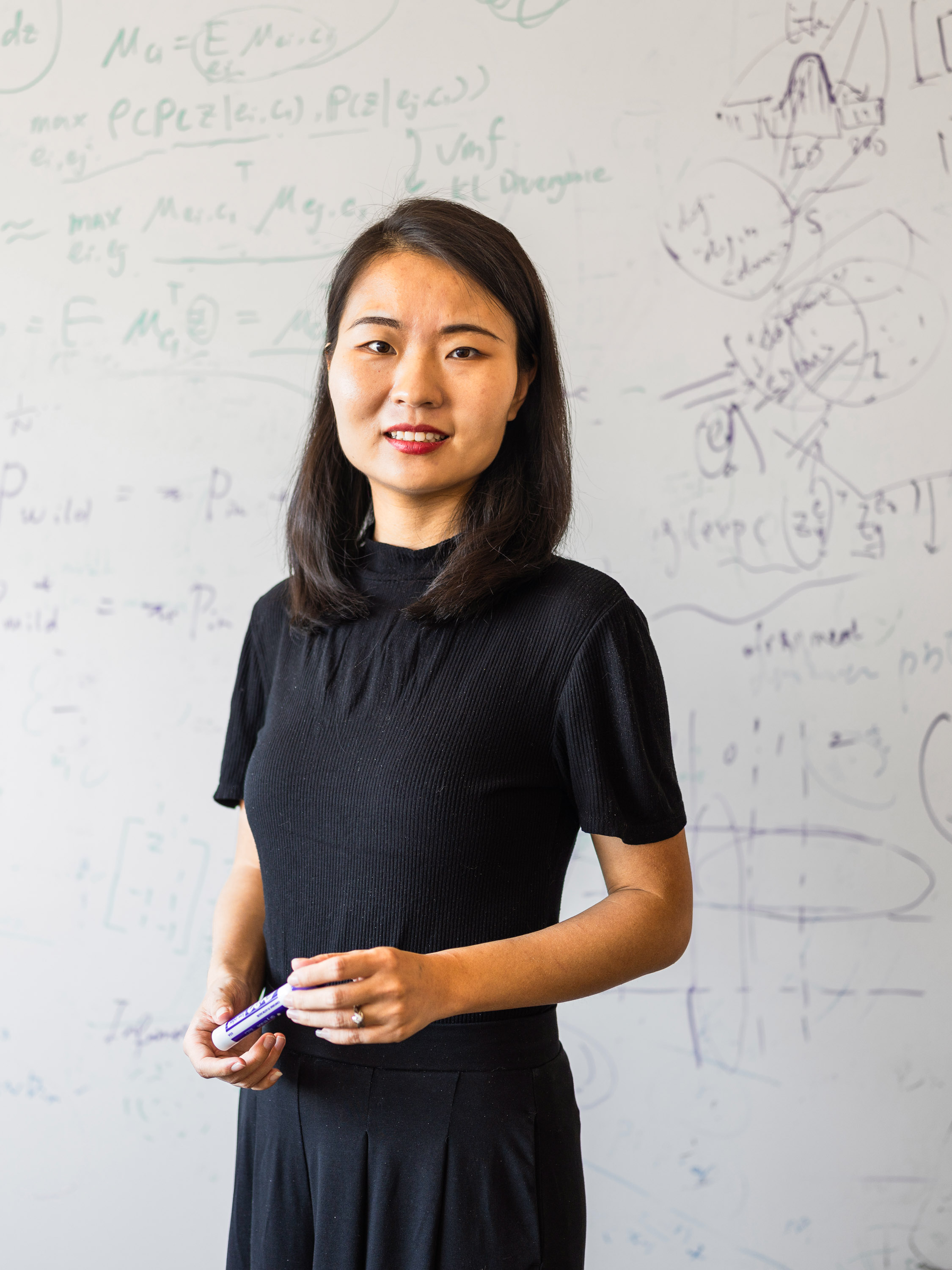

Innovadora del año 2023: Sharon Li quiere garantizar la seguridad de los nuevos modelos de IA

CIENCIAS DE LA COMPUTACIÓN / INTELIGENCIA ARTIFICIAL.

La investigación de Li podría evitar que los modelos de inteligencia artificial fallen de forma catastrófica cuando se encuentren con escenarios desconocidos.

Sharon Li es la Innovadora del Año 2023 de MIT Technology Review. Conozca al resto de Innovadores menores de 35 de este año.

A medida que lanzamos nuevos sistemas de inteligencia artificial (IA) del laboratorio al mundo real, necesitamos estar prepararnos ante posibles fallos sorprendentes y potencialmente catastróficos. Es algo que ya está ocurriendo. Por ejemplo, el año pasado un brazo robótico fracturó en Moscú el dedo de un niño de siete años. El robot agarró el dedo del niño mientras este movía una pieza de ajedrez. Solo lo soltó después de que los adultos que estaban cerca consiguieran abrirle las garras. Esto no ocurrió porque el robot estuviera programado para hacer daño, sino porque estaba demasiado seguro de que el dedo del niño era una pieza de ajedrez.

Este incidente es un ejemplo clásico de algo que Sharon Li (32 años) quiere evitar. Li, profesora adjunta de la Universidad de Wisconsin, Madison (EE UU), es pionera en una función de seguridad de IA llamada detección fuera de distribución (OOD, por sus siglas en inglés). Tal y como ella lo describe, esta función ayuda a los modelos de IA a determinar cuándo deben abstenerse de actuar si se enfrentan a algo para lo que no han sido entrenados.

Li desarrolló uno de los primeros algoritmos sobre detección fuera de distribución para redes neuronales profundas. Desde entonces, Google ha creado un equipo dedicado a integrar la detección de OOD en sus productos. El año pasado, el análisis teórico de Li sobre la detección de OOD fue elegido entre más de 10.000 propuestas como artículo destacado por NeurIPS, una de las conferencias de IA más prestigiosas.

Estamos inmersos en la fiebre del oro de la IA, y las empresas tecnológicas se apresuran a lanzar sus modelos. Sin embargo, la mayoría de ellos están entrenados para identificar cosas específicas, y a menudo fallan cuando se encuentran con los escenarios desconocidos típicos del desordenado e impredecible mundo real. Su incapacidad para comprender de forma fiable lo que "saben" y lo que "no saben" es el punto débil que se esconde tras muchos desastres de la IA.

El trabajo de Li insta a la comunidad de la IA a replantearse su enfoque de la formación. "Muchos de los enfoques clásicos de los últimos 50 años no son conscientes de la seguridad", afirma. Su enfoque acepta la incertidumbre utilizando el aprendizaje automático para detectar datos desconocidos en el mundo y diseñar modelos de IA que se adapten a ellos sobre la marcha. La detección de datos fuera de distribución podría ayudar a evitar accidentes cuando los coches autónomos chocan con objetos desconocidos en la carretera o a hacer más útiles los sistemas de IA médica para descubrir una nueva enfermedad. "En todas esas situaciones, lo que realmente necesitamos es un modelo de aprendizaje automático consciente de la seguridad que sea capaz de identificar lo que no sabe", afirma Li.

Este enfoque también podría ayudar a la tecnología de IA más en boga hoy en día: los grandes modelos lingüísticos como ChatGPT. Estos modelos son mentirosos confiados, que presentan falsedades como hechos. Aquí es donde la detección de OOD podría ayudar. Pongamos que una persona le hace a un chatbot una pregunta para la que no tiene respuesta en sus datos de entrenamiento. En lugar de inventarse algo, un modelo de IA que utilice la detección de OOD se negaría a responder.

La investigación de Li aborda una de las cuestiones más fundamentales del aprendizaje automático, dice John Hopcroft, profesor de la Universidad de Cornell (EE UU), que fue su asesor de doctorado. Su trabajo también ha despertado el interés de otros investigadores. "Lo que está haciendo es poner a trabajar a otros investigadores", afirma Hopcroft, quien añade que Li "básicamente ha creado uno de los subcampos" de la investigación sobre seguridad de la IA.

Ahora, Li trata de comprender mejor los riesgos de seguridad relacionados con los grandes modelos de IA, que están impulsando todo tipo de nuevas aplicaciones y productos en línea. Así, espera que hacer más seguros los modelos subyacentes a estos productos pueda mitigar los riesgos de la IA. "El objetivo final es garantizar un aprendizaje automático fiable y seguro", afirma.

Sharon Li es una de las Innovadoras menores de 35 2023 de MIT Technology Review. Conozca al resto de galardonados de este año.

Por: Melissa Heikkilä.

Sitio Fuente: MIT Technology Review