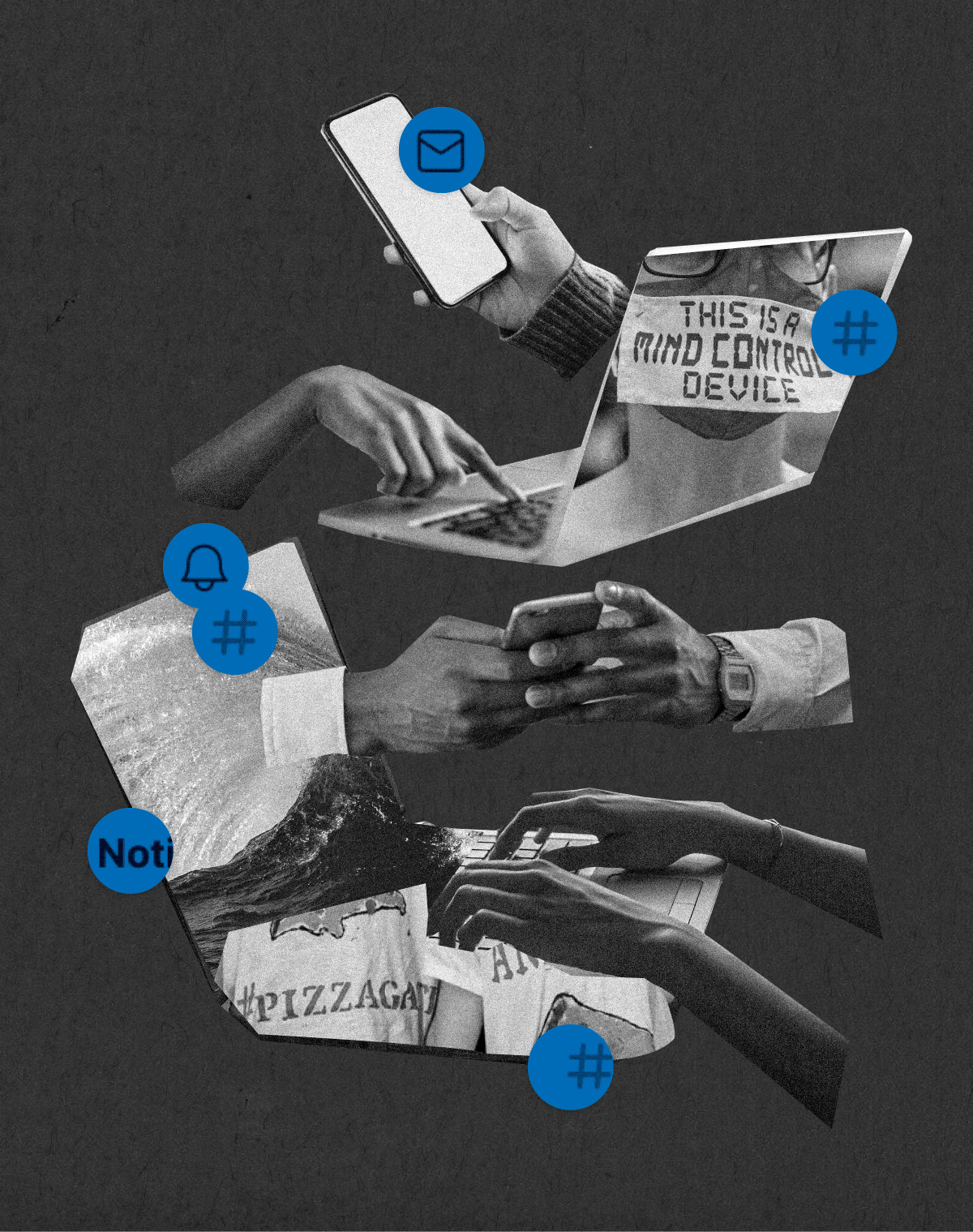

Historia de cómo las redes sociales ayudaron a destruir la verdad

COMUNICACIÓN / REDES SOCIALES.

Las plataformas han acelerado y escalado la desinformación, pero el problema es inherentemente humano. Y, mientras los responsables, mayoritariamente hombres blancos, siguen sin tomar medidas enérgicas, QAnon, los antivacunas y las campañas coordinadas de acoso siguen floreciendo.

Najeebah Al-Ghadban.

Más de cinco millones y medio de personas han muerto a causa de la pandemia de coronavirus (COVID-19). Y, a pesar de que las vacunas están logrando aplacar la crisis sanitaria, la desinformación y el negacionismo pandémico siguen inundando las redes sociales.

Padres de barrios residenciales, inmersos en propaganda de salud online, difunden memes de Facebook y aparecen sin mascarilla en las tiendas, cámara en mano empeñados en obligar a los trabajadores mal pagados a que les dejen acceder al establecimiento. Milicias armadas de derecha patrullan las ciudades occidentales, creyendo los rumores online de la invasión de los activistas antifascistas (los Antifa). Y luego está QAnon, la teoría de la conspiración online que asegura que Trump está librando una guerra secreta contra un círculo de pedófilos satanistas.

QAnon obtuvo una nueva energía de la incertidumbre y del pánico, causados por la pandemia, convirtiéndose en una "teoría de la omniconspiración": un río rugiente alimentado por docenas de corrientes de pensamiento conspirativo. Los investigadores han documentado cómo QAnon amplifica la desinformación sanitaria sobre la COVID-19 y se infiltra en otras campañas online ocultando sus creencias estrambóticas bajo una versión más aceptable para la corriente principal. "Q", la cuenta anónima tratada por los creyentes de QAnon como si fuera un profeta, instruyó a sus seguidores a "camuflarse" online y "eliminar todas las referencias sobre: 'Q', 'Qanon', etcétera para evitar la prohibición / anulación". Las comunidades de bienestar, los grupos de padres, las iglesias y las organizaciones de derechos humanos intentan lidiar con la propagación de esta peligrosa teoría de la conspiración entre sus miembros.

Cuando Pew Research encuestó a los estadounidenses sobre QAnon a principios de 2020, solo el 23 % de los adultos sabía poco o mucho al respecto. Cuando la organización volvió a preguntar a la gente a principios de septiembre, ese número se había duplicado, y la forma en la que pensaban sobre el movimiento se dividió en las líneas partidistas, según explica Pew: "El 41 % de los republicanos que sabían algo sobre QAnon creen que es bueno o muy bueno para el país". En cambio, el 77 % de los demócratas piensa que era "muy malo".

Las principales plataformas como Facebook y Twitter han empezado a tomar fuertes medidas contra las cuentas de QAnon y las redes de desinformación. Facebook prohibió por completo los grupos de QAnon, apuntando directamente a una de las redes de distribución de la teoría de la conspiración más poderosas. Pero, durante años, esas redes florecieron de forma relativamente tranquila en las redes sociales. Parece que la represión de QAnon llegó demasiado tarde, como si las plataformas estuvieran intentando detener la inundación de un río con cubos de agua.

Muchos estadounidenses, especialmente los blancos, han vivido el aumento del odio online y de la desinformación como si estuvieran en un puente muy alto por encima de ese río desbordado, mirando solo al horizonte. A medida que sube el agua, se lleva a todos los que no lograron conseguir una posición tan segura y resistente. Actualmente, ese puente no es lo suficientemente alto, e incluso las personas que están sobre él pueden sentir las mortales corrientes.

Creo que mucha gente considera que esta creciente marea de desinformación y odio no existió hasta que les tocó los tobillos. Antes, el agua simplemente no estaba allí, y, si estaba, tal vez era un pequeño chorro o un arroyo.

Pero si queremos saber cómo este problema se volvió tan grande y grave, hay que ver cuántas personas intentaron avisarnos sobre él.

Aguas crecientes.

"Todo el mundo dice, 'No lo vi venir'", afirma la emprendedora y analista Shireen Mitchell. A principios de la década de 2010, fue una de los muchos investigadores negros que documentaron las campañas coordinadas de Twitter de acoso y desinformación contra feministas negras. En Twitter. Y añade: "Lo vimos venir. Lo seguíamos".

La llamé a principios de septiembre de 2020, aproximadamente una semana después de que Twitter decidiera eliminar un puñado de cuentas que pretendían representar a antiguos demócratas negros reconvertidos en partidarios de Trump.

Hacerse pasar por personas negras en Twitter es una táctica ya antigua. En 2014, las activistas feministas negras Shafiqah Hudson y I'Nasah Crockett notaron que las cuentas de Twitter que supuestamente promocionaban hashtags feministas negros cómo #EndFathersDay y #whitewomencantberaped tenían algo extraño. Todo sobre esas cuentas (la elección de palabras, las biografías, los nombres de usuario) parecía representar la imagen que un trol racista de derechas tenía sobre las feministas negras. Y eso es exactamente lo que eran. Como se señaló en un artículo extenso de Slate sobre su trabajo, Crockett y Hudson descubrieron centenares de cuentas falsas en ese momento y documentaron cómo funcionaba la campaña.

"No nos consideran actores fiables... sino demasiado comprometidos, no como un grupo de interés suficientemente válido".

Al igual que Mitchell, Hudson y Crockett, que figuran entre los primeros y mejores expertos en cómo funciona el acoso online, han acabado siendo su blanco. Pero muchos de esos mismos expertos han visto su investigación cuestionada, tanto por las plataformas de redes sociales donde florece el abuso grupal, como por una nueva línea de voces influyentes, a menudo blancas, en los círculos académicos y entre los periodistas que se han ganado la vida traduciendo la cultura de los memes online para un público más amplio.

"Las personas transexuales en su conjunto han acumulado una gran cantidad de experiencia en cómo lidiar con este problema", señala la estudiante de doctorado en la Universidad de Washington (EE. UU.) Katherine Cross, especializada en el estudio del abuso online y que es una mujer negra transexual. Y añade: "Los conocimientos que descubrimos se ignoran por muchas de las mismas razones. No nos consideran actores fiables, sino demasiado comprometidos, no como un grupo de interés suficientemente válido, siempre. Y eso también ha sido guardado en el agujero de la memoria, creo".

Muchos de los periodistas, como yo, que tienen grandes plataformas para escribir sobre la cultura de internet, son blancos. Desde las elecciones en las que ganó Trump en 2016, varios de nosotros nos hemos convertido en las voces de quienes quieren saber cómo operan sus seguidores online, en qué creen y cómo se vuelven virales. Pero muchos de nosotros, inconscientemente, hemos ayudado a construir los mecanismos que se han utilizado para difundir el abuso.

La cultura de los memes irónicos ha florecido en los últimos 10 años, con el racismo y el sexismo a menudo explicados por reporteros blancos como un simple humor viral. Pero el camino que tomaron esas bromas hacia la corriente principal, que se originó en foros como 4Chan, antes de su lavado por los periodistas para la esfera pública, es la misma ruta que se utiliza para difundir los mensajes de QAnon, la desinformación sobre la salud y el abuso dirigido. La forma en la que los periodistas cubrieron los memes ayudó a enseñar a los supremacistas blancos exactamente cómo salirse con la suya.

La profesora asistente de la Universidad de Syracuse (EE. UU.) Whitney Phillips, que estudia la desinformación online, publicó un informe en 2018 que documenta cómo los periodistas que cubren la desinformación realizan un servicio vital y corren el riesgo de intensificar los fenómenos dañinos al mismo tiempo. Es algo que Phillips, que es blanca, ha vivido personalmente. Y señala: "No sé si hay un momento específico que me mantiene despierta por la noche, pero existe una reacción específica que sí lo hace. Y yo diría que es la risa". La risa de otros y la suya propia.

Mitchell y yo hablamos durante casi dos horas en septiembre de 2020, me explicó cómo se sentía, a veces, al ver nuevas voces blancas entrando y saliendo de su campo de especialización. En muchas solicitudes de entrevista, a menudo se le pide reformular sus propias experiencias para un "público no profesional", es decir, para gente blanca. Mientras tanto, las opiniones de los expertos de las comunidades más dañadas por el abuso online se tratan, en el mejor de los casos, como de importancia secundaria y, a menudo, se omiten por completo.

Un ejemplo: gamergate, la campaña de abuso online de 2014 que atacaba a mujeres y periodistas de la industria del juego. Comenzó con la maliciosa diatriba online de un hombre sobre su exnovia (blanca). Se convirtió en una gran historia cultural y noticia e hizo que el público en general se tomara el acoso online más en serio, pero al mismo tiempo demostró cómo las campañas de abuso siguen funcionando continuamente.

Incluso entonces, según Cross, las personas en mejores condiciones de hablar sobre por qué estas campañas ganaron tanta relevancia y qué podría detenerlas, es decir, las personas que sufrían esos ataques no fueron tomadas en serio como expertas. Cross era una de ellas, escribiendo sobre gamergate y siendo su víctima a la vez. Mitchell me contó que después del gamergate la atención de los medios hacia el abuso online creció por una simple razón: "Finalmente prestaron atención cuando una mujer blanca sufrió esos ataques, pero no cuando pasaba lo mismo a una mujer negra".

Y, a medida que algunas empresas empezaban a intentar hacer algo frente al abuso, los involucrados en tales esfuerzos a menudo se convertían en blanco de exactamente el mismo tipo de acoso.

Cuando Ellen Pao asumió el cargo de CEO de Reddit en 2014, supervisó el primer intento real del sitio para enfrentarse a la misoginia, al racismo y al abuso que existía allí. En 2015, Reddit introdujo nuevas normas contra el acoso y luego prohibió cinco conocidos subreddits por violarlas. Los redditores molestos con esas prohibiciones atacaron a Pao y lanzaron peticiones pidiendo su renuncia. Pao acabó renunciando más tarde ese año y actualmente es defensora de la diversidad en la industria de la tecnología.

Hablé con Pao en junio de 2020, justo después de que Reddit prohibiera r/The_Donald, un subreddit proTrump que antes era popular y que durante años sirvió como espacio de organización para amplificar los mensajes extremistas alimentados por la conspiración. Pao llevaba años instando a los líderes de Reddit a prohibirlo. Cuando por fin pasó, muchos de sus suscriptores ya se habían trasladado a otras plataformas, como Gab, con menos probabilidades de tomar medidas enérgicas contra ellos.

Pao admite: "Siempre ha sido más fácil no hacer nada. No se necesitan recursos. No hace falta dinero. Siempre se puede seguir no haciendo nada".

Un diluvio constante.

Las advertencias de Pao, Cross y otros no acababan de penetrar en la conciencia general. Las aguas de la inundación regresaban una y otra vez.

El viernes previo a que Donald Trump fuera elegido presidente de EE. UU. en 2016, otra teoría de la conspiración, que aproximadamente un año después ayudaría a crear QAnon, fue tendencia en Twitter. #SpiritCooking fue fácil de desmentir. Sus afirmaciones centrales eran que el presidente de la campaña de Hillary Clinton, John Podesta, era un ocultista, y que una cena ofrecida por una destacada artista especializada en performances era en realidad un ritual satánico secreto. La fuente de la teoría fue una invitación a la cena encontrada en los archivos de correo electrónico robados de Podesta, que WikiLeaks había hecho público en octubre de ese año.

Escribí sobre la desinformación durante las elecciones de 2016 y vi cómo #SpiritCooking evolucionó a Pizzagate, la teoría de la conspiración sobre las redes secretas de pedófilos en pizzerías. Reddit prohibió el foro de Pizzagate a finales de noviembre de ese año por hacer "doxxing" a personas (es decir, poner su información personal online). El 4 de diciembre de 2016, exactamente un mes después de que explotara #SpiritCooking, un hombre de Carolina del Norte (EE. UU.) entró en un restaurante, que fue uno de los blancos de los creyentes de Pizzagate, levantó su rifle AR-15 y abrió fuego.

Los primeros meses tras las elecciones de 2016 marcaron otro punto de inflexión, al igual que ocurre actualmente, cuando la avalancha de desinformación fue suficiente para que más gente de la habitual se diera cuenta. A muchos sorprendidos por la victoria de Trump les preocupaba que la interferencia extranjera y la difusión de noticias falsas en las redes sociales hubieran influido en los votantes. El CEO de Meta, Mark Zuckerberg, primero lo descartó como "una idea bastante loca", pero el subsiguiente análisis de las plataformas de redes sociales por parte de los medios, los gobiernos y el público reveló que, en efecto, las redes sociales podrían radicalizar y dañar a las personas, especialmente a las que ya son vulnerables.

Y el problema siguió creciendo. El sistema de recomendaciones de YouTube, diseñado para que las personas vean tantos vídeos como sea posible, llevó a los espectadores por los túneles de la desinformación y el odio generados por los algoritmos. En Twitter, Trump usaba continuamente su enorme plataforma para difundir a los partidarios que promovían las ideologías racistas y conspirativas. En 2017, Facebook introdujo la transmisión de vídeos en directo y pronto acabó inundado de vídeos en vivo de violencia gráfica. En 2019, incluso antes de la COVID-19, la desinformación sobre vacunas florecía en esta plataforma mientras que el sarampión se extendía por EE. UU.

"La elección de tener a personas cuyo objetivo principal consiste en lanzar constantemente discursos de odio… es una decisión. Nadie los ha obligado a tomarla".

Las empresas tecnológicas respondieron con una nueva serie de soluciones: contratar a una enorme cantidad de moderadores; desarrollar sistemas automatizados para detectar y eliminar algunos tipos de contenido extremo o la desinformación; actualizar las normas, algoritmos y políticas para prohibir o disminuir el alcance de algunas formas de contenido dañino.

Pero, de momento, la marea tóxica ha superado su capacidad, o su voluntad, para derrotarla. Sus modelos de negocio dependen de maximizar la cantidad de tiempo que los usuarios pasan en sus plataformas. Además, como han demostrado varios estudios, la desinformación se origina desproporcionadamente en las fuentes de derecha, lo que deja a las plataformas tecnológicas abiertas a acusaciones de sesgo político si intentan suprimirla. En algunos casos, según informó NBC News en agosto, Facebook evitó deliberadamente tomar medidas disciplinarias contra páginas populares de derecha que publicaban información errónea que infringía las reglas de la plataforma.

Muchos expertos creían que la próxima prueba a gran escala de la capacidad de estas empresas para manejar la avalancha de desinformación, odio y extremismo coordinados serían las elecciones estadounidenses de noviembre de 2020. Pero primero vino la pandemia de la COVID-19: un fértil caldo de cultivo para las noticias de curas falsas, teorías de conspiración sobre el origen del virus y propaganda en contra las pautas de salud pública y el sentido común.

Si eso sirve de ejemplo, las plataformas no tendrían el poder de evitar la difusión de las noticias falsas sobre el fraude electoral, la violencia en las calles y el recuento de votos después de las elecciones.

La tormenta y la inundación.

No pretendo contarles la política mágica que solucionaría todo esto, ni juzgar qué tendrían que hacer las plataformas para absolverse de esta responsabilidad. En cambio, me gustaría señalar, igual que lo han hecho otros antes, que existía la opción de intervenir mucho antes, pero no se hizo. Facebook y Twitter no crearon a los extremistas racistas, ni las teorías de conspiración ni el acoso coordinado, pero eligieron gestionar sus plataformas de una forma que permitiera a los extremistas encontrar un público e ignoraron las voces que les alertaban sobre los daños que sus modelos de negocio potenciaban.

A veces, estas alertas provenían de sus propias empresas y círculos sociales. Cuando la comunicadora científica Ariel Waldman hizo pública su historia de abuso en Twitter, no esperaba convertirse en objeto de acoso en esa misma plataforma. Era mayo de 2008.

Antes de publicarlo, ya llevaba un año intentado eliminar a sus abusadores de la plataforma en privado, pero seguía siendo bastante optimista cuando decidió publicar un blog detallando sus experiencias. Al fin y al cabo, Waldman conocía a algunas de las personas que habían fundado Twitter solo un par de años antes.

Hace un tiempo me contó: "Solía pasar por su oficina y nos conocíamos. Yo iba a sus fiestas de Halloween". También había ejemplos de éxito en ese momento: Flickr, el sitio web para compartir fotos, había respondido ágilmente a las solicitudes para eliminar el contenido abusivo dirigido a ella.

Así que escribió sobre las amenazas y los insultos que había recibido y detalló sus correos electrónicos con los fundadores de la empresa. Pero Twitter nunca abordó adecuadamente ese abuso. Catorce años después, Waldman ha visto repetirse el mismo patrón año tras año.

Afirma: "La elección de tener a personas cuyo objetivo principal consiste en lanzar discursos de odio y dañar a otras personas en una plataforma constantemente, es una decisión. Nadie los ha obligado a tomarla. Son ellos mismo que toman esa decisión. Y creo que cada vez más actúan como si fuera... bueno, más complicado de lo que es. Pero realmente no creo que lo sea".

No sé qué decir sobre cómo detener la inundación. Y aunque lo supiera, eso no eliminaría el enorme daño causado por las aguas crecientes. Las consecuencias en esas voces que se convirtieron en notas a pie de página cuando intentaron advertirnos son permanentes.

Mitchell señala que hoy en día, los mismos grupos que participaron en las campañas grupales de abuso y daño se postulan como víctimas cada vez que las principales plataformas intentan silenciarlos. "Si han tenido el derecho de hacer estragos durante todo ese tiempo, y se les quita, entonces creen que ellos son los que acaban oprimidos. Mientras tanto, nadie presta atención a las personas que están realmente oprimidas", señala la experta.

Una vía para mejorar las cosas podría implicar ofrecer más incentivos para que las empresas hagan algo. Eso podría incluir reformular la Sección 230, la ley que protege a las redes sociales de responsabilidad legal por el contenido publicado por los usuarios.

La profesora de la Universidad de Miami (EE. UU.) Mary Anne Franks, que ha trabajado en el tema del acoso online, cree que una reforma significativa de la ley provocaría dos cosas: limitaría el alcance de esas protecciones al discurso en vez de a la conducta y eliminaría la inmunidad de las empresas que a sabiendas se benefician de la propagación viral del odio o de la desinformación.

Pao señala que las empresas también podrían tomarse estos problemas más en serio si sus directivos se parecieran más a las personas que sufren ese acoso. "Hay que conseguir que personas de distintos orígenes lleguen a altos niveles de dirección para tomar las decisiones difíciles", y añade que eso es lo que hicieron en Reddit: "Simplemente incorporamos a varias personas de diferentes orígenes raciales y étnicos, principalmente mujeres, que entendían los problemas y veían por qué necesitábamos el cambio. Pero actualmente, estas empresas tienen juntas directivas llenas de hombres blancos que no se oponen a esos problemas y se centran en las métricas equivocadas".

Phillips, de Syracuse, es más escéptica. Su libro 'You Are Here', que publicó a principios de 2020 junto con su compañero Ryan Milner, define el abuso online y la desinformación como un desastre ecológico global, que, igual que el cambio climático, está profundamente arraigado en el comportamiento humano, tiene un largo contexto histórico y lo abarca todo, contaminando el ambiente.

Considera que pedir a las empresas tecnológicas que resuelvan un problema que ayudaron a crear no funcionará. Y afirma: "Es un hecho que la tecnología, nuestras redes, la forma en la que se propaga la información, dieron lugar al infierno. Esas mismas cosas no nos sacarán de esto. La idea de que habrá alguna solución escalable es solo una utopía. Es un problema humano. La tecnología lo promueve y lo intensifica exponencialmente. Pero al final, se trata de personas y de sus creencias".

Cross está de acuerdo, pero tiene una pequeña esperanza de que la conciencia por fin esté cambiando. Y concluye: "Es imposible negar que esto, como la arena, se ha metido en todas partes, incluidos los lugares que no sabíamos que existían. Tal vez cause un despertar. No sé si soy demasiado optimista, pero creo que al menos ahí están las semillas. Los ingredientes para ese tipo de cosas ya están. Y quizás pueda ocurrir. Pero tengo mis dudas".

Por: Abby Ohlheiser | traducido por Ana Milutinovic.

Sitio Fuente: MIT Technology Rewiew